🗣 SL提问: ai中的渐变

✍️ Ai批改: 在AI(特别是深度学习)中,渐变(Gradient)是一个核心概念,指损失函数(Loss Function)对模型参数(如权重、偏置)的偏导数,表示参数变化时损失函数的变化方向和速率。它是优化算法(如梯度下降)的关键,帮助模型逐步调整参数以最小化损失。

1、渐变的核心作用

方向指导:渐变指向损失函数增长最快的方向,负渐变方向即为参数优化的方向。

参数更新:优化器(如SGD、Adam)利用渐变调整参数,公式为:

\[

\theta_{new} = \theta_{old} \alpha \cdot \nabla_\theta \mathcal{L}(\theta)

\]

其中 \(\alpha\) 是学习率,\(\nabla_\theta \mathcal{L}(\theta)\) 是损失函数对参数 \(\theta\) 的渐变。

2、如何计算渐变?

反向传播(Backpropagation):神经网络通过链式法则逐层计算渐变,从输出层反向传递误差到输入层。

步骤:

1、前向传播计算预测值。

2、计算损失(如交叉熵、均方误差)。

3、反向传播计算每个参数的偏导数。

自动微分(Autograd):现代框架(如PyTorch、TensorFlow)自动计算渐变,无需手动推导。

3、渐变相关的关键问题

梯度消失/爆炸:

消失:深层网络中渐变逐层变小,导致底层参数无法更新(常见于Sigmoid激活函数)。

爆炸:渐变逐层指数增大,导致参数剧烈震荡(可通过梯度裁剪缓解)。

局部最优与鞍点:高维空间中,渐变可能停滞在非全局最优点(如Adam优化器可缓解)。

4、实际应用中的技巧

学习率调整:渐变大小影响参数更新步长,需配合动态学习率(如学习率衰减、预热)。

优化器选择:

SGD:基础梯度下降,可能震荡。

Momentum:加入惯性,加速收敛。

Adam:自适应学习率,结合动量。

5、代码示例(PyTorch)

python

import torch

定义模型和损失

model = torch.nn.Linear(2, 1)

criterion = torch.nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

前向传播

inputs = torch.tensor([[1.0, 2.0]])

targets = torch.tensor([[3.0]])

outputs = model(inputs)

loss = criterion(outputs, targets)

反向传播计算渐变

optimizer.zero_grad() 清零旧渐变

loss.backward() 计算新渐变

print(model.weight.grad) 打印权重的渐变

参数更新

optimizer.step()

总结

渐变是AI模型训练的“指南针”,决定了参数优化的方向和幅度。理解其计算、问题及优化方法,对设计高效模型至关重要。实际应用中需结合优化器、学习率策略等工具应对挑战。

0

IP地址: 172.135.159.137

搜索次数: 11

提问时间: 2025-04-24 11:34:57

❓️ 热门提问:

有什么好推广的游戏

伦敦金多少钱一克

php制作网页

aicxtek

香港黄金行情

90g黄金

卖化妆品网站

深圳金银珠宝

成都金控集团方兆

品质质量承诺金句

豌豆Ai站群搜索引擎系统

🤝 关于我们:

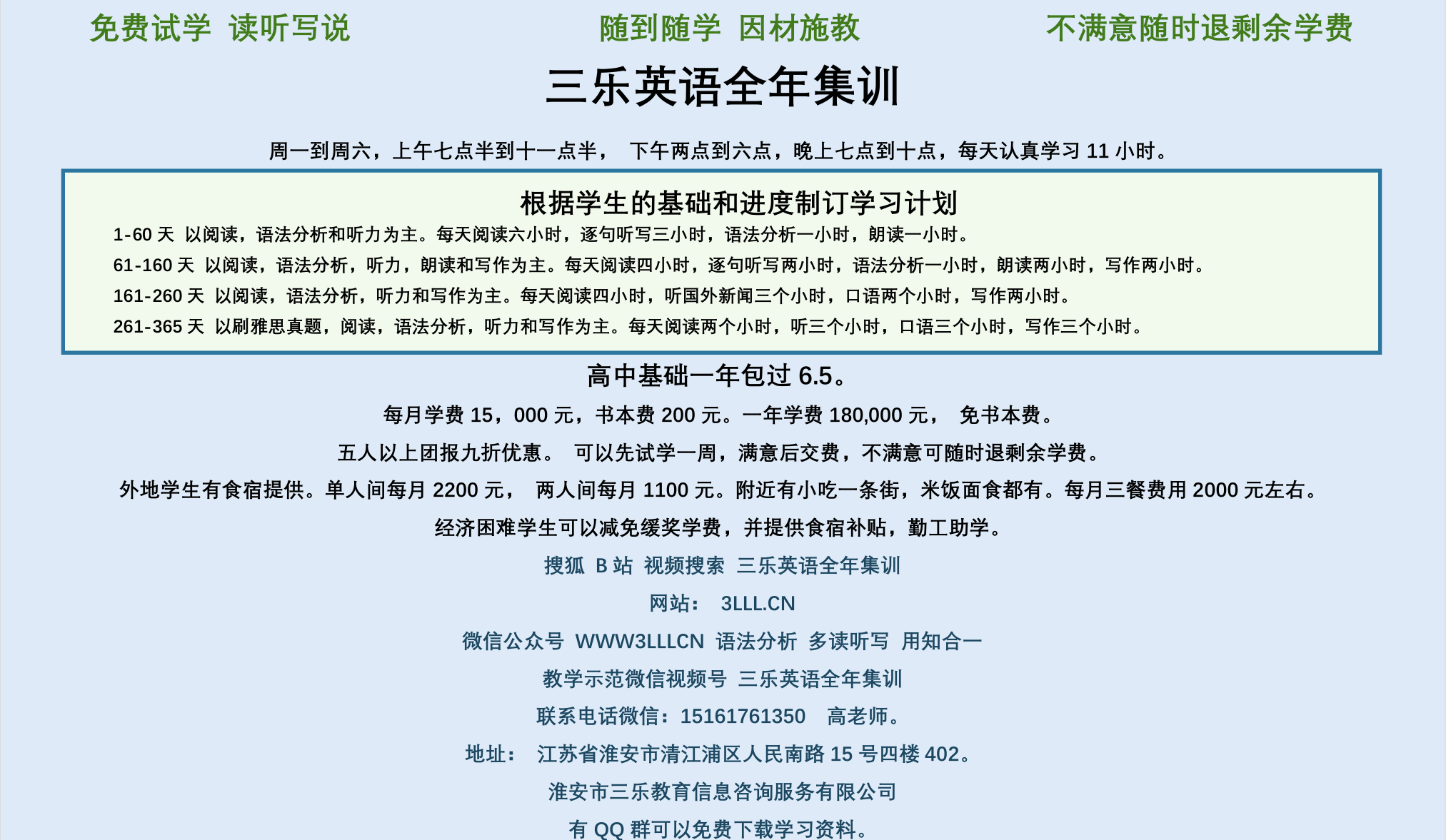

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。